简介

随着人工智能技术的迅速发展,移动机器人导航在拥挤的行人环境中有许多重要的应用,如医院、商场和食堂。在这些人群密集的场景中,安全高效地引导机器人是一个至关重要但仍然具有挑战性的问题。 目前的解决方案可以分为两类:基于模型的和基于学习的。基于模型的方法主要是利用社交交互的显式模型来扩展现有的多智能体碰撞避免解决方法。然而,模型参数需要针对不同的应用场景进行调整。最近的研究成功地使用深度强化学习来学习有效的策略,这些策略隐含地模拟了操作和交互。 多智能体状态的规划和预测是许多问题的基础,包括在有N个非合作智能体的环境中进行决策的一般情况。在这篇文章中,介绍了一种基于模型的关系图学习[1]方法来解决这个问题,该方法可以同时预测未来的人类运动和人群导航计划。

问题假设

本文要解决的问题是,机器人在人群中以最快最安全的方式向目标点行驶。

深度强化学习方法

这个任务被表述为一个序列决策问题。每个智能体(无论是人还是机器人)观察其他人的可观察状态,包括位置 p = [p_x,p_y],速度v = [v_x,v_y]和半径r(尺寸的抽象度量)。每个智能体还保持一个内部状态,例如目标位置p_g和首选速度v_{pref}。假设动作是瞬时的,znt 总是在下一个时间步到达目标位置。使用用s^t_0和s^t_i分别表示机器人状态和观察到的人类i在时间t的状态。从状态S到动作a^t的策略映射可表示为  其中,R(S_t,a_t)是在时间t收到的奖励,γ∑(0,1)是折扣因子,V^\star是最优值函数,P(S_t,a_t,S_{t+{\Delta}{t}})是从时间t到时间t+\Delta{t}的转移概率。

其中,R(S_t,a_t)是在时间t收到的奖励,γ∑(0,1)是折扣因子,V^\star是最优值函数,P(S_t,a_t,S_{t+{\Delta}{t}})是从时间t到时间t+\Delta{t}的转移概率。

图学习的模型预测

人与人之间的相互作用(即空间关系)对于机器人导航和预测未来人类运动非常重要。在这里,将人群建模为一个图,推理所有智能体之间的关系,并使用GCN来计算机器人和人类的状态表示。  人群导航的关键挑战是学习所有智能体之间群体编码交互的表示。在这里将人群和机器人建模为有向图G_t= (V_t,E_t),其中|V| = N +1。边e_{i,j}∈ E表示智能体i对智能体j的关注程度或者智能体j对智能体i的重要性。这种成对关系不是先验已知的,所以用成对相似性函数(关系推断)来推断。在推断出所有智能体之间的关系后,图神经网络将信息从一个节点传播到另一个节点,并计算所有智能体的状态表示(交互建模).

人群导航的关键挑战是学习所有智能体之间群体编码交互的表示。在这里将人群和机器人建模为有向图G_t= (V_t,E_t),其中|V| = N +1。边e_{i,j}∈ E表示智能体i对智能体j的关注程度或者智能体j对智能体i的重要性。这种成对关系不是先验已知的,所以用成对相似性函数(关系推断)来推断。在推断出所有智能体之间的关系后,图神经网络将信息从一个节点传播到另一个节点,并计算所有智能体的状态表示(交互建模).

前瞻性规划和学习

在本节中提出如何使用简化的MCTS方法来增强关系图学习,并在决策时提供有远见的策略[2]。不完美的学习值函数会由于局部极小而导致次优行为。在先前单步规划的基础上,可以进一步模拟未来的d步,以提供状态值的更好估计。此外,通过控制该模拟的深度d,通过权衡计算量以获得更好的性能。未来d步的价值可表示为  对于d步规划,计算量随着搜索深度和宽度呈指数增长。由于动作空间大,可以使用动作空间裁剪来降低计算成本。价值函数直观的估计进入状态的质量。使用这个估计,递归地搜索前w个下一个状态,并向前看一步。与只考虑顶层动作相比,当智能体遇到不可见的状态时,d步规划提供了更好的状态值估计。 本文使用简化的方法,有兴趣可以对MCTS方法进行扩展阅读。

对于d步规划,计算量随着搜索深度和宽度呈指数增长。由于动作空间大,可以使用动作空间裁剪来降低计算成本。价值函数直观的估计进入状态的质量。使用这个估计,递归地搜索前w个下一个状态,并向前看一步。与只考虑顶层动作相比,当智能体遇到不可见的状态时,d步规划提供了更好的状态值估计。 本文使用简化的方法,有兴趣可以对MCTS方法进行扩展阅读。

联合价值估计和状态预测学习

首先使用模仿学习和从演示者ORCA[3]策略中收集的经验来初始化模型,然后使用RL来细化策略。模仿学习对于策略初始化很重要,因为导航中的回报很少,没有模仿学习就无法收敛。然后使用强化学习中的经验缓存训练端到端的预测函数,得到价值预测和状态预测。进一步对机器人的多步导航策略进行学习。

仿真

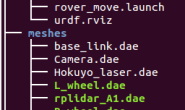

我们使用crowdnav 模拟环境。本实验的代码开源在 https://github.com/ChanganVR/RelationalGraphLearning  在这个模拟中,人类由ORCA控制,其参数从高斯分布中采样以引入行为多样性。实验中使用圆交叉场景。穿越圆的场景中,N = 5个人随机位于半径为4m的圆上,他们的x,y坐标上添加了随机扰动。代理的最大速度为1米/秒,目标是固定的,因此可以在最短的8秒钟内达到。为了充分评估所提出模型的有效性,加入了机器人对人类不可见的模拟环境。结果,模拟的人类只对人类做出反应,而不对机器人做出反应。这个设置是一个干净的测试平台,用于验证模型在不影响人类行为的情况下推理人机交互的能力。所有模型都用500个随机测试用例进行评估。 按照说明对仿真环境进行配置,可根据需求自行修改环境中的人群数量,对不同策略进行测试。

在这个模拟中,人类由ORCA控制,其参数从高斯分布中采样以引入行为多样性。实验中使用圆交叉场景。穿越圆的场景中,N = 5个人随机位于半径为4m的圆上,他们的x,y坐标上添加了随机扰动。代理的最大速度为1米/秒,目标是固定的,因此可以在最短的8秒钟内达到。为了充分评估所提出模型的有效性,加入了机器人对人类不可见的模拟环境。结果,模拟的人类只对人类做出反应,而不对机器人做出反应。这个设置是一个干净的测试平台,用于验证模型在不影响人类行为的情况下推理人机交互的能力。所有模型都用500个随机测试用例进行评估。 按照说明对仿真环境进行配置,可根据需求自行修改环境中的人群数量,对不同策略进行测试。

结论

本文介绍了关系图学习方法来解决人群导航问题。通过将人-机器人和人-人的交互表示为一个图,并使用GCNs来计算交互特征。通过d步规划,模型在特定的搜索预算下明确地规划未来。实验表明,本模型能够处理具有挑战性的导航场景。

参考

[1] C. Chen, S. Hu, P . Nikdel, G. Mori, and M. Savva, “Relational graph learning for crowd navigation,” arXiv preprint arXiv:1909.13165, 2019. [2] Oh, J., Singh, S., Lee, H. , “Value prediction network,” Advances in Neural Information Processing Systems , pp. 6118-6128, 2017. [3] J. van den Berg, S. J. Guy, M. Lin, and D. Manocha, “Reciprocal n-body collision avoidance,” in Robotics Research, ser. Springer Tracts in Advanced Robotics, C. Pradalier, R. Siegwart, and G. Hirzinger, Eds. Springer Berlin Heidelberg, pp. 3–19.