摘要:本文主要研究了HDFS文件系统的读写流程以及基于MRS在windows客户端下读写HDFS文件的实现。

HDFS(Hadoop分布式文件系统)是Apache Hadoop项目的一个子项目。

HDFS支持海量数据的存储,允许用户把成百上千的计算机组成存储集群,其中的每一台计算机称为一个节点。用户通过HDFS的终端命令可以操作其中的文件和目录,如同操作本地文件系统(如Linux)中的文件一样。用户也可以通过HDFS API或MapReduce来编程访问其中的文件数据。

本文主要研究了HDFS文件系统的读写流程以及基于MRS在windows客户端下读写HDFS文件的实现。

1. HDFS的架构和元数据

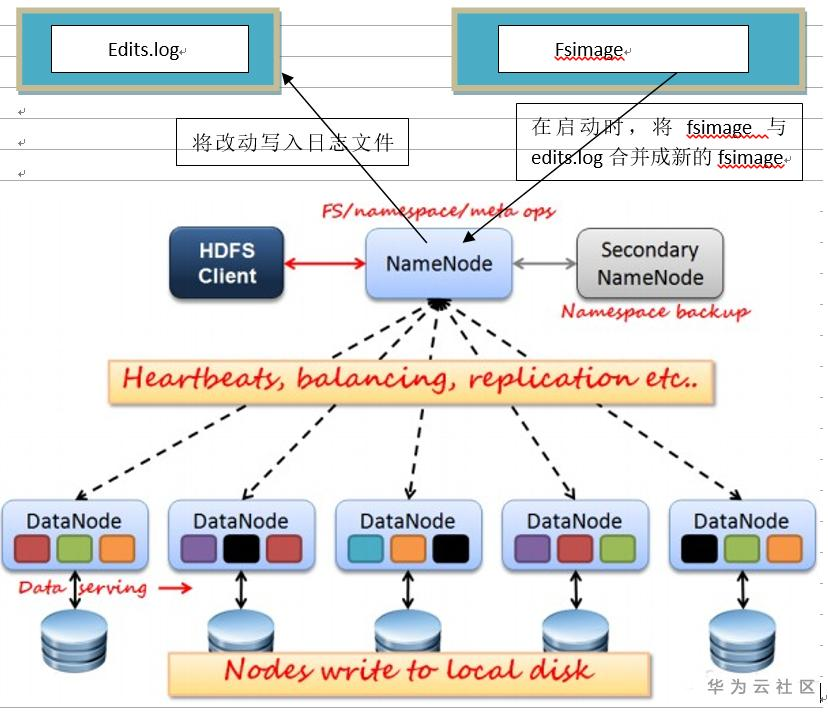

1.1 HDFS采用master/slaves主从结构模型管理数据,结构模型图如下

1.2 元数据的相关概念

Fsimage:文件系统映射文件,也是元数据的镜像文件(磁盘中),存储某段时间namenode内存元数据信息

Edits log:操作日志文件

1.3 元数据的工作特点

- (1) namenode始终在内存中存储元数据,使得“读操作”更加快

- (2)写请求时,向edits文件写入日志,成功返回后才修改内存,并向客户端返回

- (3) NameNode内存中存储的是=fsimage+edits

2. 文件的读写流程

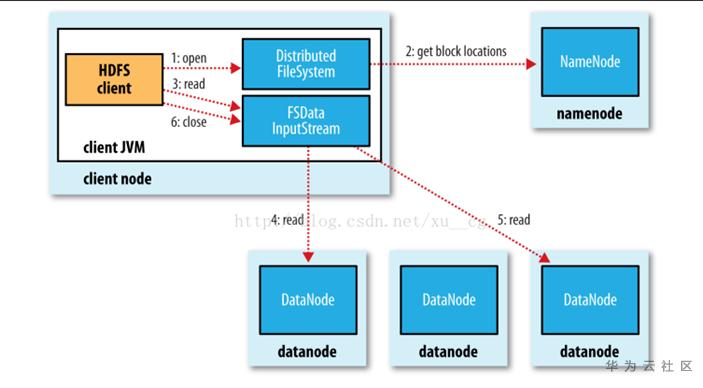

2.1 文件的读取流程

1) 客户端Client调用FileSystem的open(),返回FSDataInputStream对象给客户端.DistributeFileSystem对象通过RPC和NameNode通信,查询元数据信息,确定文件路径是否存在以及检查权限,返回这个文件的数据块位置列表(数据块位置是有先后顺序)

2) 客户通过FSDataInputStream read()方法读取数据.FSDataInputStream对象按照数据块位置优先顺序建立一条连接,读取数据.当此数据块读取完毕后,FSDataInputStream对象关闭和此数据节点的连接,然后继续按照优先顺序建立下一个数据块连接,读取数据…….在据读取过程中,如果客户端在与数据节点通信时出现错误,则会尝试读取包含有此数据块的下一个数据节点,并且失败的数据节点会被记录,以后不会再连接

3) 当数据读取完毕后,调用FSDataInputStream对象的close()函数。

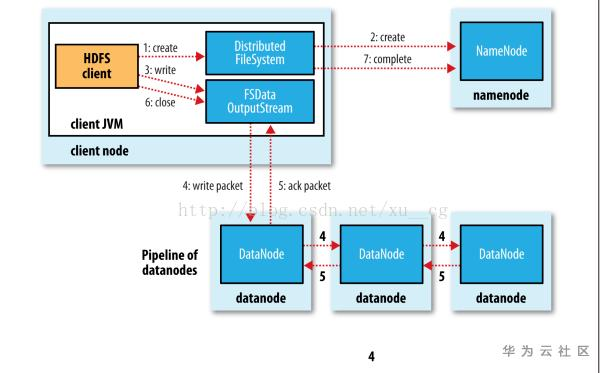

2.2 文件的写入流程

1)客户端Client调用FileSystem的create()函数,返回FSDataOutputStream对象给客户端DistributedFileSystem对象通过RPC与namenode通信,确定文件存在不存在以及是否有创建文件的权限,先将操作写入log,再载入内存,将DataNode列表返回

2) 客户端通过FSDataOutputStream对象,写数据.FSDataOutputStream对象将数据按照128M分成块,写入Data Queue.然后将DataNode列表和Data Queue通过DataNode列表一同发送给最近的DataNode.这样之后client端和NameNode分配的多个DataNode构成pipeline管道.client每次向第一个DataNode写入一个packet,这个packet便会直接在pipeline里传给第二个、第三个DataNode.每个DataNode写完一个块后,会返回确认信息. FSDataoutputStream将确认信息保存在ACK Queue.所有的数据块写入pipeline中的数据节点,并且ACK Queue成功返回.

3) FSDataOutputStream对象close()方法关闭流.通知元数据节点写入完毕

3. 基于华为云MRS windows下读写HDFS的实现

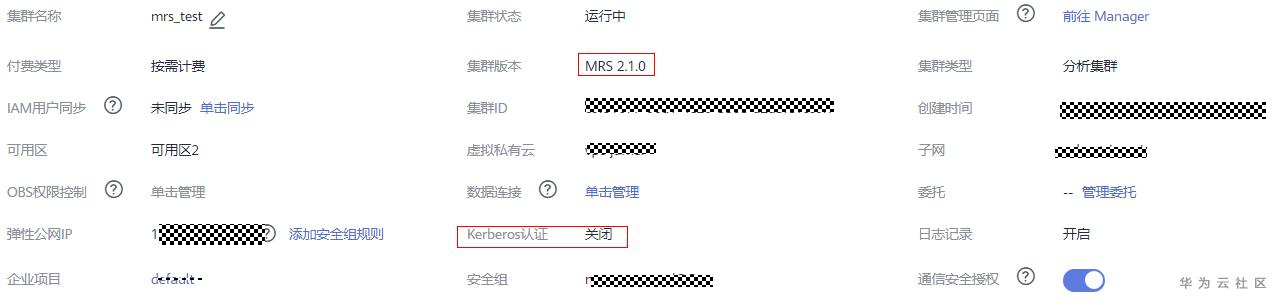

3.1 创建2.1.0非安全集群

3.2 安全组规则入方向放开windows 客户端ip和所有端口

3.3 为集群的各个节点绑定弹性ip

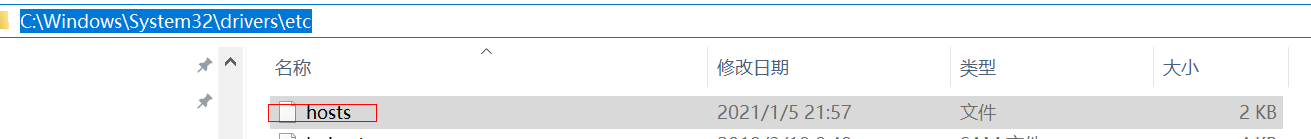

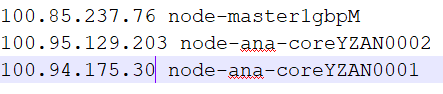

3.4 将弹性ip和集群节点主机名写入windows的hosts文件

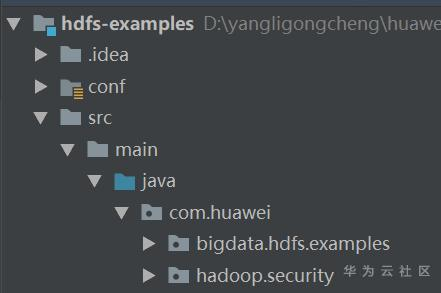

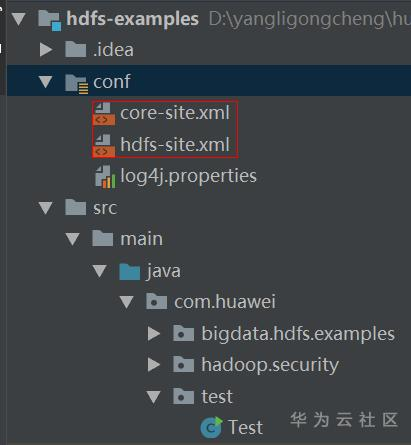

3.5 打开https://github.com/huaweicloud/huaweicloud-mrs-example/tree/mrs-2.1,将样例代码下载下来,然后是idea打开hdfs-examples项目

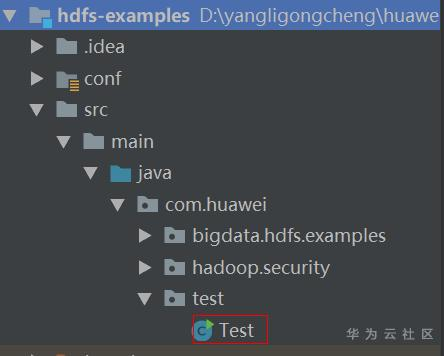

3.6 在huawei下面创建test文件夹,并且Test.java文件放到这个文件夹内

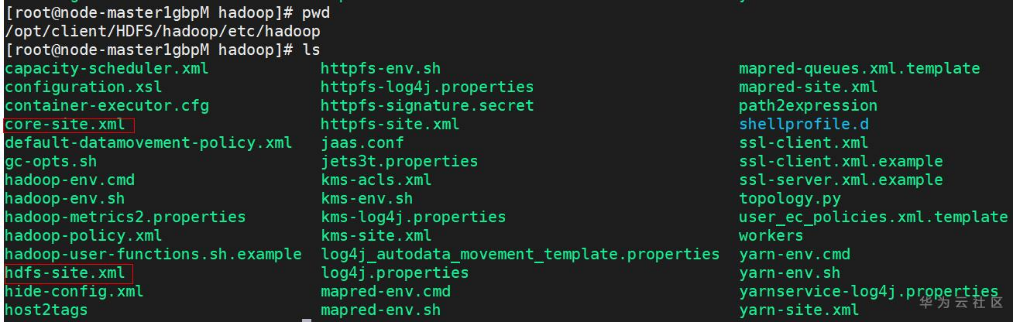

3.7 从集群下载配置文件,置于项目conf文件夹下

3.8 将下面配置配置于hdfs-site.xml中

<property>

<name>dfs.client.use.datanode.hostname</name>

<value>true</value>

</property>

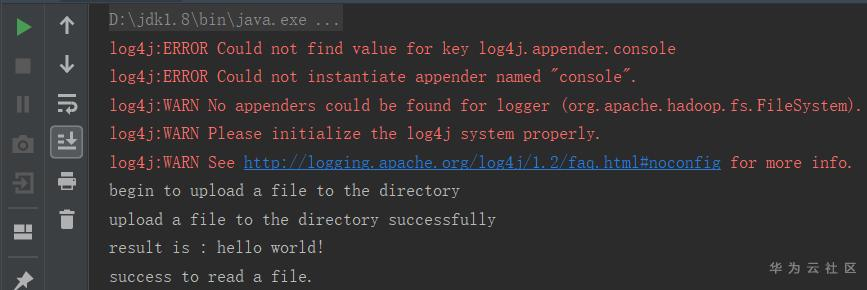

3.9 idea执行程序,执行结果如下

附件下载:

Test.rar 1.06KB

文档.docx 455.30KB

本文分享自华为云社区《HDFS读写原理和代码简单实现》,原文作者:剑指南天 。

点击关注,第一时间了解华为云新鲜技术~